近期,银河游戏国际网站曹进德教授团队在分布式学习优化研究方面取得重要进展,相关成果“Decentralized Inexact Proximal Gradient Method With Network-Independent Stepsizes for Convex Composite Optimization” 在信号处理领域国际顶刊《IEEE Transactions on Signal Processing》 上正式发表。曹进德教授为通讯作者,其博士生郭璐瑶为第一作者。《IEEE Transactions on Signal Processing》是由 IEEE 信号处理学会主办的信号处理领域最高水平学术期刊之一。

分布式学习优化是新一代人工智能中的一类重要问题。论文聚焦国家自然科学基金“十四五”规划中的“数据科学和人工智能中的优化模型、算法设计与分析”和“数据与计算科学的基础理论与算法”等重要基础方向,瞄准突破了分布式环境中的学习优化算法对于异质数据不鲁棒、参数选取高度依赖于网络拓扑结构、非光滑情形收敛较慢等重难点问题。针对在不交换梯度敏感信息下是否可以实现参数网络无关、私有损失函数非光滑情形是否可以实现线性收敛等公开挑战问题。论文提出了一种新颖的具有异质数据鲁棒性的去中心化学习优化算法,在只涉及状态通信的条件下,该算法首次实现了比集中式算法更大而且与网络拓扑结构无关的非协调步长。

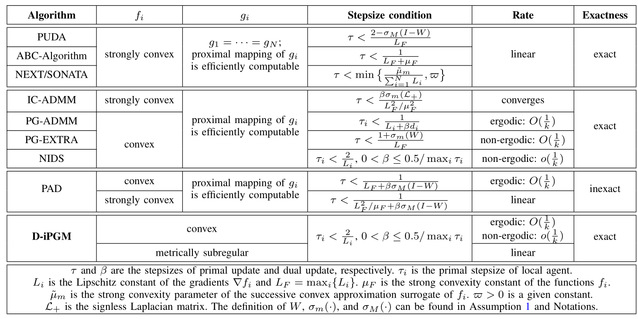

表1-1.算法收敛条件与收敛性质的对比结果

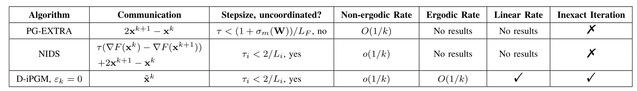

表1-2.D-iPGM的精确迭代版本与PG-EXTRA和NIDS算法的对比结果

此外,该算法允许近似求解近邻算子(无需任何局部通信),这有利于高效解决非光滑损失函数的近邻算子不存在解析解的情形。论文从理论层面严格证明了该算法的收敛性以及较温和条件下的线性收敛速率,与现有算法的对比结果如表1-1和1-2所示,算法在收敛条件、收敛速率、通信复杂度等方面都具备一定的优势。

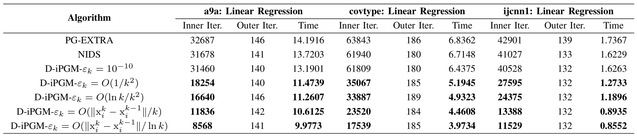

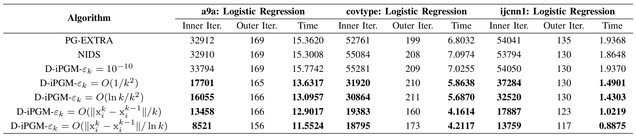

为了测试算法的有效性,论文在具有50个节点的随机网络上,利用a9a、covtype、ijcnn1这三个真实数据集进行了实验,结果如表2所示。

表2.实验结果:PG-EXTRA、NIDS、D-iPGM对于a9a、covtype、ijcnn1数据集上的带有一般LASSO正则器的线性和Logistic回归问题的性能表现比较